Полезное:

Как сделать разговор полезным и приятным

Как сделать объемную звезду своими руками

Как сделать то, что делать не хочется?

Как сделать погремушку

Как сделать так чтобы женщины сами знакомились с вами

Как сделать идею коммерческой

Как сделать хорошую растяжку ног?

Как сделать наш разум здоровым?

Как сделать, чтобы люди обманывали меньше

Вопрос 4. Как сделать так, чтобы вас уважали и ценили?

Как сделать лучше себе и другим людям

Как сделать свидание интересным?

Категории:

АрхитектураАстрономияБиологияГеографияГеологияИнформатикаИскусствоИсторияКулинарияКультураМаркетингМатематикаМедицинаМенеджментОхрана трудаПравоПроизводствоПсихологияРелигияСоциологияСпортТехникаФизикаФилософияХимияЭкологияЭкономикаЭлектроника

Информационная энтропия. Энтропия в биологии

|

|

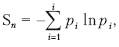

Информационная энтропия служит мерой неопределенности сообщений. Сообщения описываются множеством величин x1, x2 xn, которые могут быть, например, словами: p1, p2 …, pn. Информационную энтропию обозначают Sn или Hu. Для определенного дискретного статистического распределения вероятностей Pi используют следующее выражение:

при условии:

Значение Sn = 0, если какая-либо вероятность Pi = 1, а остальные вероятности появления других величин равны нулю. В этом случае информация достоверна, то есть неопределенность в информации отсутствует. Информационная энтропия принимает наибольшее значение, когда Pi равны между собой и неопределенность в информации максимальна.

Общая энтропия нескольких сообщений равна сумме энтропий отдельных сообщений (свойство аддитивности).

Американский математик Клод Шеннон, один из создателей математической теории информации, использовал понятие энтропии для определения критической скорости передачи информации и при создании «помехоустойчивых кодов». Такой подход (использование из статистической термодинамики вероятностной функции энтропии) оказался плодотворными в других направлениях естествознания.

Понятие энтропии, как показал впервые Э. Шредингер (1944 г.), а затем Л. Бриллюэн и др., существенно и для понимания многих явлений жизни и даже деятельности человека.

Теперь ясно, что с помощью вероятностной функции энтропии можно анализировать все стадии перехода системы от состояния полного хаоса, которому соответствуют равные значения вероятностей и максимальное значение энтропии, к состоянию предельно возможной упорядоченности, которому соответствует единственно возможное состояние элементов системы.

Живой организм с точки зрения протекающих в нем физико-химических процессов можно рассматривать как сложную открытую систему, находящуюся в неравновесном, нестационарном состоянии. Для живых организмов характерна сбалансированность процессов обмена, ведущих к уменьшению энтропии. Конечно, с помощью энтропии нельзя охарактеризовать жизнедеятельность в целом, так как жизнь не сводится к простой совокупности физико-химических процессов. Ей свойственны другие сложные процессы саморегуляции.

Вопросы для самопроверки

1. Сформулируйте законы движения Ньютона.

2. Перечислите основные законы сохранения.

3. Назовите общие условия справедливости законов сохранения.

4. Объясните существо принципа симметрии и связь этого принципа с законами сохранения.

5. Сформулируйте принцип дополнительности и принцип неопределенности Гейзенберга.

6. В чем состоит «крушение» лапласовского детерминизма?

7. Как формулируются постулаты Эйнштейна в СТО?

8. Назовите и объясните релятивистские эффекты.

9. В чем состоит суть ОТО?

10. Почему невозможен вечный двигатель первого рода?

11. Объясните понятие кругового процесса в термодинамике и идеальный цикл Карно.

12. Объясните понятие энтропии как функцию состояния системы.

13. Сформулируйте второе начало термодинамики.

14. Объясните суть понятия «неравновесная термодинамика».

15. Как качественно определяется изменение энтропии при химических реакциях?

Date: 2015-09-18; view: 620; Нарушение авторских прав