Полезное:

Как сделать разговор полезным и приятным

Как сделать объемную звезду своими руками

Как сделать то, что делать не хочется?

Как сделать погремушку

Как сделать так чтобы женщины сами знакомились с вами

Как сделать идею коммерческой

Как сделать хорошую растяжку ног?

Как сделать наш разум здоровым?

Как сделать, чтобы люди обманывали меньше

Вопрос 4. Как сделать так, чтобы вас уважали и ценили?

Как сделать лучше себе и другим людям

Как сделать свидание интересным?

Категории:

АрхитектураАстрономияБиологияГеографияГеологияИнформатикаИскусствоИсторияКулинарияКультураМаркетингМатематикаМедицинаМенеджментОхрана трудаПравоПроизводствоПсихологияРелигияСоциологияСпортТехникаФизикаФилософияХимияЭкологияЭкономикаЭлектроника

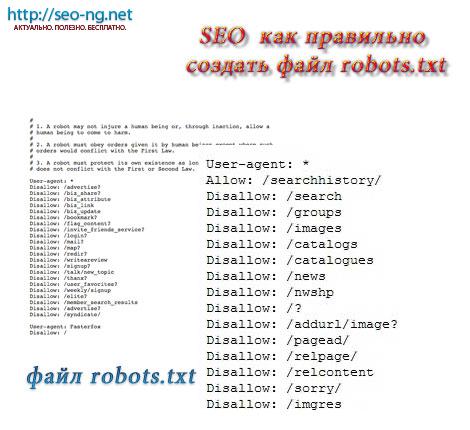

SEO как правильно создать файл robots.txt

|

|

- Категория: Раскрутка|

- Автор: iNF

|| 12.01.2013

Роботс – самый обычный текстовый документ в основном каталоге веб-ресурса. В нём содержатся все инструкции для поисковых роботов. С данным файлом можно запрещать индексацию некоторых разделов и страниц на сайте, можно указывать главное зеркало и путь к документуsitemap. Всю полезность документа robots.txt можно ярко наблюдать на примере удаления из индекса некоторых технических разделов на Вашем ресурсе. Если технический раздел Вашего веб-ресурса открыт для индексации, поисковый робот постарается исправить это средством выброса из индекса данной страницы, из-за чего индекс могут потерять и остальные страницы сайта.

Как создается файл robots.txt? А создается файл robots.txt с помощью самого обычного блокнота. После этого файл нужно поместить в основную, то есть, корневую папку веб-ресурса. Первое, что обязуется сделать каждый робот при посещении Вашей страницы – прочитать инструкции для себя в данном документе.

Как настроить роботс правильно?

Что бы правильно настроить файл robots.txt чаще всего используют две основные (есть и дополнительные) директивы: Disallow, которая отвечает за файлы, которые не будут индексировать и user-agent – директива, отвечающая за то, к какому именно роботу относятся эти запреты. Пример настройки: User-agent:* Disаllow:/ - в таком виде файл будет запрещать индексирование всего сайта для всех роботов-поисковиков. Если же после Disallow написать путь к какому-либо документу, то этот документ индексироваться не будет. Не стоит забывать простое правило: никогда не пишите пару путей к файлам в одну строку, данная строка работать не будет. Если же Вы наоборот хотите открыть какой-то файл или директорию к индексации, то пользоваться нужно командой Allow.

Вспомогательные директивы для robots.txt.

Директиву Host используют тогда, когда Ваш сайт обладает несколькими зеркалами. Данная директива указывает главное зеркало веб-ресурса. Только этот файл будет находиться в выдачах поисковых систем. sitemap помогает роботу поисковику найти файл с картой Вашего веб-ресурса.

Crawl-delay директива используется для того, чтобы создать задержки между загрузками страниц Вашего веб-ресурса роботом-поисковиком. Это очень полезная директива, если Ваш веб-сайт имеет очень много страниц.

К примеру: Crawl-delay: 5 будет означает то, что пауза между загрузками страниц составляет 5 секунд.

Request-rate директива отвечает за периоды загрузок страниц поисковым роботом.

К примеру: request-rate: 1/10 означает, что поисковый робот будет загружать страницу раз в десять секунд.

Visit-time директива определит время, через которое Ваш сайт будет доступен пользователям. Время устанавливается по шкале Гринвича – Visit-time: 0400-0600.

К чему может привести неправильная настройка документа?

Неправильно настроенный robots.txt может привести к тому, что для поиска будут открыты разделы, которые наоборот должны быть скрытыми, к примеру, с конфиденциальной информацией и наоборот: разделы с важной информацией, которые должны индексироваться – не будут иметь индекса.

Узнать правильно Вы настроили документ или нет очень легко. Для этого нужно воспользоваться сервисом вебмастер.yandex.

| <== предыдущая | | | следующая ==> |

| натрия гидрокарбонат | | | Бакалавриатқа студенттерді қабылдау бойынша статистикалық мәліметтер |

Date: 2016-07-22; view: 299; Нарушение авторских прав