Полезное:

Как сделать разговор полезным и приятным

Как сделать объемную звезду своими руками

Как сделать то, что делать не хочется?

Как сделать погремушку

Как сделать так чтобы женщины сами знакомились с вами

Как сделать идею коммерческой

Как сделать хорошую растяжку ног?

Как сделать наш разум здоровым?

Как сделать, чтобы люди обманывали меньше

Вопрос 4. Как сделать так, чтобы вас уважали и ценили?

Как сделать лучше себе и другим людям

Как сделать свидание интересным?

Категории:

АрхитектураАстрономияБиологияГеографияГеологияИнформатикаИскусствоИсторияКулинарияКультураМаркетингМатематикаМедицинаМенеджментОхрана трудаПравоПроизводствоПсихологияРелигияСоциологияСпортТехникаФизикаФилософияХимияЭкологияЭкономикаЭлектроника

Энтропия информации

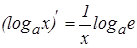

Э нтропия – содержательность, мера неопределенности информации.

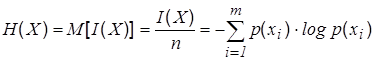

Э нтропия – математическое ожидание H(x) случайной величины I(x) определенной на ансамбле {Х, р(х)}, т.е. она характеризует среднее значение количества информации, приходящееся на один символ.

. (6)

. (6)

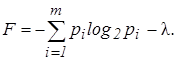

Определим максимальное значение энтропии Hmax(x). Воспользуемся методом неопределенного множителя Лагранжа -l для отыскания условного экстремума функции [6]. Находим вспомогательную функцию:

(7)

(7)

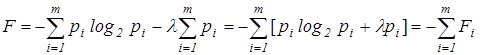

Представим вспомогательную функцию F в виде:

. (8)

. (8)

Найдем максимум этой функции

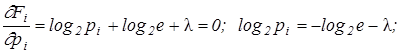

т. к.

т. к.

.

.

Как видно из выражения, величина вероятности pi не зависит от i, а это может быть в случае, если все pi равны, т.е. p1 =p2 =…=pm =1/m.

При этом выражение для энтропии равновероятных, независимых элементов равно:

. (9)

. (9)

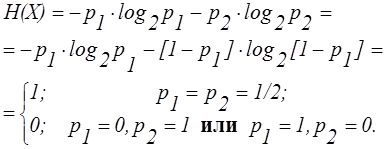

Найдем энтропию системы двух альтернативных событий с вероятностями p1 и p2. Энтропия равна:

Энтропия источника при наличии Корреляционных связей между буквами.

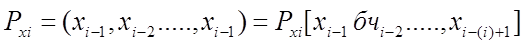

В реальных источниках буквы появляются с различной вероятностью, причем эта вероятность зависит от того какие буквы предшествовали рассматриваемой. Т.е. такие источники формируют последовательность, которая подчиняется закономерностям цепи Моркова. Напомним, что цепью Моркова порядка 1 называется такая последовательность зависимых испытаний, при которой вероятность появления какой-то реализации при этом испытании зависит от результатов 1 предыдущих испытаний и не зависит от результатов (1+1) и более ранних опытов.

Таким образом, с точки зрения прогнозирования вероятности появления очередной буквы, нас интересуют предыдущие 1 букв (предыстория на 1 шагов назад).

Если источник имеет алфавит длиной п, то можно составить  различных слов, каждое из которых будет определять с какой вероятностью появится та или иная последующая буква. Обозначим текущее конкретное состояние источника буквой q, а вероятность перехода источника в это состояние

различных слов, каждое из которых будет определять с какой вероятностью появится та или иная последующая буква. Обозначим текущее конкретное состояние источника буквой q, а вероятность перехода источника в это состояние  ,. Тогда учитывая, что максимальное число таких состояний r можно записать, что

,. Тогда учитывая, что максимальное число таких состояний r можно записать, что  . Если считать, что источник уже перешел в q-ое состояние, то можно задать условными вероятностями появление отдельных букв алфавита на его выходе

. Если считать, что источник уже перешел в q-ое состояние, то можно задать условными вероятностями появление отдельных букв алфавита на его выходе  . Очевидно, что

. Очевидно, что  .

.

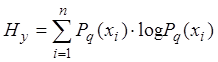

Тогда условная энтропия источника (при условии, что он находится в фиксированном q-ом состоянии):

Для перехода к безусловной энтропии необходимо усреднить условную энтропию с учетом вероятностей перехода источника в различные состояния.

Задание:

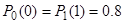

1. Определить энтропию бинарного симметричного источника, т.е. при отсутствии корреляционных связей.

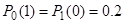

2. Определить энтропию источника, если в нем имеются корреляционные связи только между соседними буквами и вероятности появления одинаковых букв равны  , а разных букв

, а разных букв  .

.

3. Определить количество информации и энтропию сообщения из пяти букв, если число букв в алфавите равно 32 и все сообщения равновероятные.

Date: 2015-07-02; view: 301; Нарушение авторских прав; Помощь в написании работы --> СЮДА... |