Полезное:

Как сделать разговор полезным и приятным

Как сделать объемную звезду своими руками

Как сделать то, что делать не хочется?

Как сделать погремушку

Как сделать так чтобы женщины сами знакомились с вами

Как сделать идею коммерческой

Как сделать хорошую растяжку ног?

Как сделать наш разум здоровым?

Как сделать, чтобы люди обманывали меньше

Вопрос 4. Как сделать так, чтобы вас уважали и ценили?

Как сделать лучше себе и другим людям

Как сделать свидание интересным?

Категории:

АрхитектураАстрономияБиологияГеографияГеологияИнформатикаИскусствоИсторияКулинарияКультураМаркетингМатематикаМедицинаМенеджментОхрана трудаПравоПроизводствоПсихологияРелигияСоциологияСпортТехникаФизикаФилософияХимияЭкологияЭкономикаЭлектроника

Алгоритм ID3

Рассмотрим критерий выбора независимой переменной, от которой будет строиться дерево.

Полный набор вариантов разбиения |X| - количество независимых переменных.

Рассмотрим проверку переменой xh, которая принимает m значений ch 1, ch 2,..., chm.

Тогда разбиение множества всех объектов обучающей выборки N по проверке переменной xh даст подмножества T 1, T 2,..., Tm.

Мы ожидаем, что при разбиении исходного множества, будем получать подмножества с меньшим числом объектом, но более упорядоченные.

Так, чтобы в каждом из них были по-возможности объекты одного класса.

Эта мера упорядоченности (неопределенности) характеризуется информацией.

В контексте рассматриваемой задачи это количество информации, необходимое для того, чтобы отнести объект к тому или иному классу.

При разделении исходного множества на более мелкие подмножества, используя в качестве критерия для разделения значения выбранной независимой переменной,

неопределённость принадлежности объектов конкретным классам будет уменьшаться. Задача состоит в том, чтобы выбрать такие независимые переменные,

чтобы максимально уменьшить эту неопределенность и в конечном итоге получить подмножества, содержащие объекты только одного класса.

В последнем случае неопределенность равна нулю.

Единственная доступная информация - каким образом классы распределены в множестве T и его подмножествах, получаемых при разбиении.

Именно она и используется при выборе переменной.

Рассмотрим пример, в котором требуется построить дерево решений относительно того, состоится ли игра при заданных погодных условиях.

Исходя из прошлых наблюдений (накопленных исторических данных), возможны четыре варианта разбиения дерева.

Пусть freq(cr,I) - число объектов из обучающей выборки, относящихся к классу cr.

Тогда вероятность того, что случайно выбранный объект из обучающего множества I будет принадлежать классу cr равняется:

.

.

Подсчитаем количество информации, основываясь на числе объектов того или иного класса, получившихся в узле дерева после разбиения исходного множества.

Согласно теории информации оценку среднего количества информации, необходимого для определения класса объекта из множества Т, даёт выражение:

(понятие информационной энтропии)

(понятие информационной энтропии)

Подставляя в эту формулу полученное значение для P, получим:  .

.

Поскольку используется логарифм с двоичным основанием, то это выражение даёт количественную оценку в битах.

Для оценки количества информации справедливы следующие утверждения:

- Если число объектов того или иного класса в получившемся подмножестве равно нулю, то количество информации также равно нулю.

- Если число объектов одного класса равно числу объектов другого класса, то количество информации максимально.

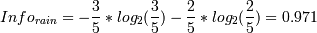

Посчитаем значение информационной энтропии для исходного множества до разбиения.

бит.

бит.

Ту же оценку, но уже после разбиения множества Т по xh даёт следующее выражение:  или

или  .

.

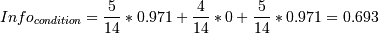

Например, для переменной "Наблюдение", оценка будет следующей:

бит.

бит.

бит.

бит.

бит.

бит.

бит.

бит.

Критерием для выбора атрибута (зависимой переменной) будет являться следующая формула:

Критерий Gain рассчитывается для всех независимых переменных после чего выбирается переменная с максимальным значением Gain.

Необходимо выбрать такую переменную, чтобы при разбиении по ней один из классов имел наибольшую вероятность появления. Это возможно в том случае, когда энтропия Infox имеет минимальное значение и, соответственно, критерий Gain(X) достигает своего максимума.

В нашем примере значение Gain для независимой переменной "Наблюдение" (перспектива) будет равно:

Gain(перспектива) = Info(I) - Info(перспектива) = 0.94 - 0.693 = 0.247 бит.

Аналогичные расчеты можно провести для других независимых переменных. В результате получаем:

Gain(наблюдение) = 0.247 бит.

Gain(температура) = 0.029 бит.

Gain(влажность) = 0.152 бит.

Gain(ветер) = 0.048 бит.

Таким образом, для первоначального разбиения лучше всего выбрать независимую переменную "Наблюдение".

Далее требуется выбрать следующую переменную для разбиения. Варианты разбиения представлены на рисунке.

Аналогичным образом можно посчитать значение Gain для каждого разбиения:

Gain(температура) = 0.571 бит.

Gain(влажность) = 0.971 бит.

Gain(ветер) = 0.02 бит.

Видно, что следующей переменной, по которой будет разбиваться подмножество T (солнечно) будет "Влажность".

Дальнейшее разбиение этой ветви уже не потребуется, т.к. в получившихся подмножествах все объекты относятся только к одному классу.

Если в процессе работы алгоритма получен узел, ассоциированный с пустым множеством (ни один объект не попал в данный узел), то он помечается как лист, и в качестве решения листа выбирается наиболее часто встречающийся класс у непосредственного предка данного листа.

| <== предыдущая | | | следующая ==> |

| Травы, применяемые в китайской медицине | | | Пропедевтическая стоматология III семестр |

Date: 2015-07-01; view: 1006; Нарушение авторских прав; Помощь в написании работы --> СЮДА... |